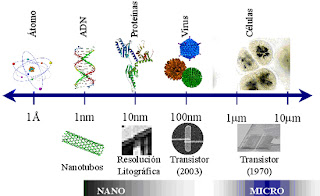

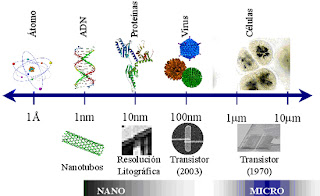

La nanotecnología es un campo de las ciencias aplicadas dedicado al control y manipulación de la materia a una escala menor que un micrómetro, es decir, a nivel de átomos y moléculas. Lo más habitual es que tal manipulación se produzca en un rango de entre uno y cien nanómetros. Para hacerse una idea de lo pequeño que puede ser un nanobot, más o menos un nanobot de 50 nanómetros tiene el tamaño de 5 capas de moléculas o átomos (depende de qué esté hecho el nanobot).

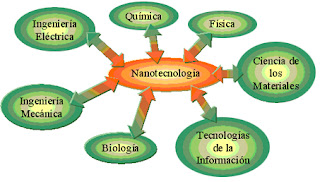

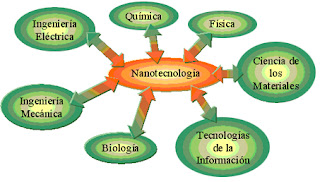

Nano- es un prefijo griego que indica una medida, no un objeto, de manera que la nanotecnología se caracteriza por ser un campo esencialmente multidisciplinar, y cohesionado exclusivamente por la escala de la materia con la que trabaja.

Definición

Definición Las nanotecnologías prometen beneficios de todo tipo, desde aplicaciones médicas nuevas o más eficientes a soluciones de problemas ambientales y muchos otros; sin embargo, el concepto de nanotecnología aún no es muy conocido en la sociedad.

Un nanómetro es la mil millonésima parte de un metro. Para comprender el potencial de esta tecnología es clave saber que las propiedades físicas y químicas de la materia cambian a escala nanométrica, lo cual se debe a efectos cuánticos. La conductividad eléctrica, el calor, la resistencia, la elasticidad, la reactividad, entre otras propiedades, se comportan de manera diferente que en los mismos elementos a mayor escala.

Aunque en las investigaciones actuales con frecuencia se hace referencia a la nanotecnología (en forma de motores moleculares, computación cuántica, etcétera), es discutible que la nanotecnología sea una realidad hoy en día. Los progresos actuales pueden calificarse más bien de nanociencia, cuerpo de conocimiento que sienta las bases para el futuro desarrollo de una tecnología basada en la manipulación detallada de las estructuras moleculares.

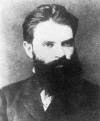

Historia El premio Nobel de Física Richard Feynman fue el primero en hacer referencia a las posibilidades de la nanociencia y la nanotecnología en el célebre discurso que dio en el Caltech (Instituto Tecnológico de California) el 29 de diciembre de 1959 titulado Al fondo hay espacio de sobra (There's Plenty Room at the Bottom).

Otro visionario de esta área fue Eric Drexler quien predijo que la nanotecnologia podría usarse para solucionar muchos de los problemas de la humanidad, pero también podría generar armas poderosisimas. Creador del Foresight Institute y autor de libros como Máquinas de la Creación Engines of Creation muchas de sus predicciones iniciales no se cumplieron, y sus ideas parecen exageradas en la opinion de otros expertos, como Richard Smalley.

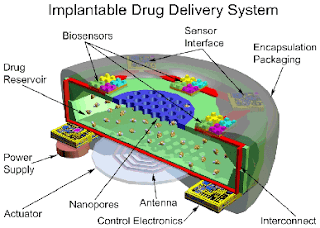

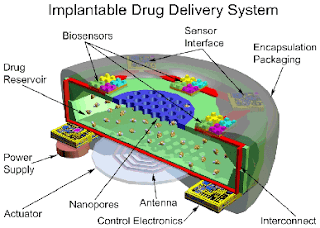

Inversión Algunos países en vías de desarrollo ya destinan importantes recursos a la investigación en nanotecnología. La nanomedicina es una de las áreas que más puede contribuir al avance sostenible del Tercer Mundo, proporcionando nuevos métodos de diagnóstico y cribaje de enfermedades, mejores sistemas para la administración de fármacos y herramientas para la monitorización de algunos parámetros biológicos.

Actualmente, alrededor de 40 laboratorios en todo el mundo canalizan grandes cantidades de dinero para la investigación en nanotecnología. Unas 300 empresas tienen el término “nano” en su nombre, aunque todavía hay muy pocos productos en el mercado.

Algunos gigantes del mundo informático como IBM, Hewlett-Packard (HP), NEC e Intel están invirtiendo millones de dólares al año en el tema. Los gobiernos del llamado Primer Mundo también se han tomado el tema muy en serio, con el claro liderazgo del gobierno estadounidense, que para este año ha destinado 570 millones de dólares a su National Nanotechnology Initiative.

En España, los científicos hablan de “nanopresupuestos”. Pero el interés crece, ya que ha habido un par de congresos sobre el tema: en Sevilla, en la Fundación San Telmo, sobre oportunidades de inversión, y en Madrid, con una reunión entre responsables de centros de nanotecnología de Francia, Alemania y Reino Unido en la Universidad Autónoma de Madrid.

Ensamblaje interdisciplinar La característica fundamental de la nanotecnología es que constituye un ensamblaje interdisciplinar de varios campos de las ciencias naturales que están altamente especializados. Por tanto, los físicos juegan un importante rol no sólo en la construcción del microscopio usado para investigar tales fenómenos sino también sobre todas las leyes de la mecánica cuántica. Alcanzar la estructura del material deseado y las configuraciones de ciertos átomos hacen jugar a la química un papel importante. En medicina, el desarrollo específico dirigido a nanopartículas promete ayuda al tratamiento de ciertas enfermedades. Aquí, la ciencia ha alcanzado un punto en el que las fronteras que separan las diferentes disciplinas han empezado a diluirse, y es precisamente por esa razón por la que la nanotecnología también se refiere a ser una tecnología convergente.

Una posible lista de ciencias involucradas sería la siguiente:

* Química (Moleculares y computacional)

* Bioquímica

* Biología molecular

* Física

* Electrónica

* Informática

Nanotecnología avanzada La nanotecnología avanzada, a veces también llamada fabricación molecular, es un término dado al concepto de ingeniería de nanosistemas (máquinas a escala nanométrica) operando a escala molecular. Se basa en que los productos manufacturados se realizan a partir de átomos. Las propiedades de estos productos dependen de cómo estén esos átomos dispuestos. Así por ejemplo, si reubicamos los átomos del grafito (compuesto por carbono, principalmente) de la mina del lápiz podemos hacer diamantes (carbono puro cristalizado). Si reubicamos los átomos de la arena (compuesta básicamente por sílice) y agregamos algunos elementos extras se hacen los chips de un ordenador.

A partir de los incontables ejemplos encontrados en la biología se sabe que miles de millones de años de retroalimentación evolucionada puede producir máquinas biológicas sofisticadas y estocásticamente optimizadas. Se tiene la esperanza que los desarrollos en nanotecnología harán posible su construcción a través de algunos significados más cortos, quizás usando principios biomiméticos. Sin embargo, K. Eric Drexler y otros investigadores han propuesto que la nanotecnología avanzada, aunque quizá inicialmente implementada a través de principios miméticos, finalmente podría estar basada en los principios de la ingeniería mecánica.

Determinar un conjunto de caminos a seguir para el desarrollo de la nanotecnología molecular es un objetivo para el proyecto sobre el mapa de la tecnología liderado por Instituto Memorial Battelle (el jefe de varios laboratorios nacionales de EEUU) y del Foresigth Institute. Ese mapa debería estar completado a finales de 2006.

Futuras aplicaciones Según un informe de un grupo de investigadores de la Universidad de Toronto, en Canadá, las diez aplicaciones más prometedoras de la nanotecnología son:

* Almacenamiento, producción y conversión de energía

* Producción agrícola

* Tratamiento y remediación de aguas

* Diagnóstico y cribaje de enfermedades

* Sistemas de administración de fármacos

* Procesamiento de alimentos

* Remediación de la contaminación atmosférica

* Construcción

* Monitorización de la salud

* Detección y control de plagas

* Informática

Riesgos potenciales Sustancias viscosas Recientemente, un nuevo estudio ha mostrado como este peligro de la “sustancia viscosa gris” es menos probable que ocurra de como originalmente se pensaba. K. Eric Drexler considera un escenario accidental con “sustancia viscosa gris” improbable y así lo declara en las últimas ediciones de Engines of Creation. El escenario “sustancia viscosa gris” clamaba la Tree Sap Answer: ¿Qué oportunidades existen que un coche pudiera ser mutado a un coche salvaje, salir fuera de la carretera y vivir en el bosque solo de savia de árbol?. Sin embargo, se han identificado otros riesgos mayores a largo plazo para la sociedad y el entorno.

Una variante de esto es la “Sustancia viscosa verde”, un escenario en que la nanobiotecnología crea una máquina nanométrica que se autoreplica que consume todas las partículas orgánicas, vivas o muertas, creando un cieno -como una masa orgánica muerta. En ambos casos, sin embargo, serían limitado por el mismo mecanismo que limita todas las formas vivas (que generalmente ya actúan de esta manera): energía disponible.

Veneno y Toxicidad A corto plazo, los críticos de la nanotecnología puntualizan que hay una toxicidad potencial en las nuevas clases de nanosustancias que podrían afectar de forma adversa a la estabilidad de las membranas celulares o distorsionar el sistema inmunológico cuando son inhaladas o digeridas. Una valoración objetiva de riesgos puede sacar beneficio de la cantidad de experiencia acumulada con los materiales microscópicos bien conocidos como el hollín o las fibras de asbestos.

Hay una posibilidad que las nanopartículas en agua de boca pudieran ser dañinas para los humanos y otros animales. Las células de colon expuestas a partículas de dióxido de titanio se ha encontrado que se descomponen a mayor velocidad de la normal. Las nanopartículas de dióxido de titanio se usan normalmente en pantallas de sol, como las hacen transparentes, comparadas con las grandes partículas de dióxido de titanio, que hacen a las pantallas de sol parecer blancas.

Armas

La militarización de la nanotecnología es una aplicación potencial. Mientras los nanomateriales avanzados obviamente tienen aplicaciones para la mejora de armas existentes y el hardware militar a través de nuevas propiedades (tales como la relación fuerza-peso o modificar la reflexión de la radiación EM para aplicaciones sigilosas), y la electrónica molecular podría ser usada para construir sistemas informáticas muy útiles para misiles, no hay ninguna manera obvia de que alguna de las formas que se tienen en la actualidad o en un futuro próximo puedan ser militarizadas más allá de lo que lo hacen otras tecnologías como la ingeniería genética. Mientras conceptualmente podríamos diseñar que atacasen sistemas biológicos o los componentes de un vehículo (es decir, un nanomáquina que consumiera la goma de los neumáticos para dejar incapaz a un vehículo rápidamente), tales diseños están un poco lejos del concepto. En términos de eficacia, podrían ser comparados con conceptos de arma tales como los pertenecientes a la ingeniería genética, como virus o bacterias, que son similares en concepto y función práctica y generalmente armas tácticamente poco atractivas, aunque las aplicaciones para el terrorismo son claras.

La nanotecnología puede ser usada para crear dispositivos no detectables – micrófonos de tamaño de una molécula o cámaras son posibilidades que entran en el terreno de lo factible. El impacto social de tales dispositivos dependería de muchos factores, incluyendo quién ha tenido acceso a él, como de bien funcionan y como son usados.

El telescopio espacial Hubble ha enviado la primera imagen de un anillo fantasmal en torno a un grumo de galaxias a 5.000 millones de años luz de la Tierra, que los astrónomos describieron hoy como la primera prueba de la existencia de la materia oscura.

El telescopio espacial Hubble ha enviado la primera imagen de un anillo fantasmal en torno a un grumo de galaxias a 5.000 millones de años luz de la Tierra, que los astrónomos describieron hoy como la primera prueba de la existencia de la materia oscura.