Introducción

Introducción

El Cálculo constituye una de las grandes conquistas intelectuales de la humanidad. Una vez construido, la historia de la matemática ya no fue igual: la geometría, el álgebra y la aritmética, la trigonometría, se colocaron en una nueva perspectiva teórica. Detrás de cualquier invento, descubrimiento o nueva teoría, existe, indudablemente, la evolución de ideas que hacen posible su nacimiento. Es muy interesante prestar atención en el bagaje de conocimientos que se acumula, desarrolla y evoluciona a través de los años para dar lugar, en algún momento en particular y a través de alguna persona en especial, al nacimiento de una nueva idea, de una nueva teoría, que seguramente se va a convertir en un descubrimiento importante para el estado actual de la ciencia y, por lo tanto merece el reconocimiento. El Cálculo cristaliza conceptos y métodos que la humanidad estuvo tratando de dominar por más de veinte siglos. Una larga lista de personas trabajaron con los métodos "infinitesimales" pero hubo que esperar hasta el siglo XVII para tener la madurez social, científica y matemática que permitiría construir el Cálculo que utilizamos en nuestros días.

Sus aplicaciones son difíciles de cuantificar porque toda la matemática moderna, de una u otra forma, ha recibido su influencia; y las diferentes partes del andamiaje matemático interactúan constantemente con las ciencias naturales y la tecnología moderna.

Newton y Leibniz son considerados los inventores del cálculo pero representan un eslabón en una larga cadena iniciada muchos siglos antes. Fueron ellos quienes dieron a los procedimientos infinitesimales de sus antecesores inmediatos, Barrow y Fermat, la unidad algorítmica y la precisión necesaria como método novedoso y de generalidad suficiente para su desarrollo posterior. Estos desarrollos estuvieron elaborados a partir de visiones de hombres como Torricelli, Cavalieri, y Galileo; o Kepler, Valerio, y Stevin. Los alcances de las operaciones iniciales con infinitesimales que estos hombres lograron, fueron también resultado directo de las contribuciones de Oresme, Arquímedes y Eudoxo. Finalmente el trabajo de estos últimos estuvo inspirado por problemas matemáticos y filosóficos sugeridos por Aristóteles, Platón, Tales de Mileto, Zenón y Pitágoras. Para tener la perspectiva científica e histórica apropiada, debe reconocerse que una de las contribuciones previas decisivas fue la Geometría Analítica desarrollada independientemente por Descartes y Fermat.

Sin la contribución de éstos y de muchos otros hombres más, el cálculo de Newton y Leibniz seguramente no existiría. Su construcción fue parte importante de la revolución científica que vivió la Europa del siglo XVII.Los nuevos métodos enfatizaron la experiencia empírica y la descripción matemática de nuestra relación con la realidad. La revolución científica supuso una ruptura con las formas de pensar, estudiar y vincularse con la naturaleza que dominaron casi absolutamente en Europa entre los siglos V y XV. Esta ruptura y salto en la historia del conocimiento estuvieron precedidos por las importantes transformaciones que se vivieron durante los siglos XV y XVI con el Renacimiento y la Reforma Protestante. El Cálculo Diferencial e Integral están en el corazón del tipo de conocimiento, cultura y de sociedad de la que, esencialmente, somos parte.

El extraordinario avance registrado por la matemática, la física y la técnica durante los siglos XVIII, XIX y XX, se lo debemos al Cálculo infinitesimal y por eso se puede considerar como una de las joyas de la creación intelectual de la que el hombre puede sentirse orgulloso.

El siglo XVII y la disputa por la creación del cálculo

En sus comienzos el cálculo fue desarrollado para estudiar cuatro problemas científicos y matemáticos:

- Encontrar la tangente a una curva en un punto.

- Encontrar el valor máximo o mínimo de una cantidad.

- Encontrar la longitud de una curva, el área de una región y el volumen de un sólido.

- Dada una fórmula de la distancia recorrida por un cuerpo en cualquier tiempo conocido, encontrar la velocidad y la aceleración del cuerpo en cualquier instante. Recíprocamente, dada una fórmula en la que se especifique la aceleración o la velocidad en cualquier instante, encontrar la distancia recorrida por el cuerpo en un período de tiempo conocido.

En parte estos problemas fueron analizados por las mentes más brillantes de este siglo, concluyendo en la obra cumbre del filósofo-matemático alemán Gottfried Wilhelm Leibniz y el físico-matemático inglés Issac Newton: la creación del cálculo. Se sabe que los dos trabajaron en forma casi simultánea pero sus enfoques son diferentes. Los trabajos de Newton están motivados por sus propias investigaciones físicas (de allí que tratara a las variables como "cantidades que fluyen") mientras que Leibniz conserva un carácter más geométrico y, diferenciándose de su colega, trata a la derivada como un cociente incremental, y no como una velocidad. Leibniz no habla de derivada sino de incrementos infinitamente pequeños, a los que llama diferenciales. Un incremento de x infinitamente pequeño se llama diferencial de x, y se anota dx. Lo mismo ocurre para y (con notación dy). Lo que Newton llamó fluxión, para Leibniz fue un cociente de diferenciales (dy/dx). No resulta difícil imaginar que, al no poseer en esos tiempos un concepto claro de límite y ni siquiera de función, los fundamentos de su cálculo infinitesimal son poco rigurosos. Se puede decir que el cálculo de fluxiones de Newton se basa en algunas demostraciones algebraicas poco convincentes, y las diferenciales de Leibniz se presentan como entidades extrañas que, aunque se definen, no se comportan como incrementos. Esta falta de rigor, muy alejada del carácter perfeccionista de la época griega, fue muy usual en la época post-renacentista y duramente criticada. Dos siglos pasaron hasta que las desprolijidades en los fundamentos del cálculo infinitesimal se solucionaron, y hoy aquel cálculo, potencialmente enriquecido, se muestra como uno de los más profundos hallazgos del razonamiento humano.

Resulta muy interesante la larga y lamentable polémica desatada a raíz de la prioridad en el descubrimiento. Al principio la disputa se realizó en el marco de la cortesía pero al cabo de tres décadas comenzó a ser ofensiva hasta que en el siglo XVIII se convirtieron en mutuas acusaciones de plagio. La polémica se tornó cada vez mayor y finalmente se convirtió en una rivalidad entre los matemáticos británicos y los continentales.

La discusión siguió hasta mucho después de la muerte de los dos grandes protagonistas y, afortunadamente, hoy ha perdido interés y la posteridad ha distribuido equitativamente las glorias. Hoy está claro que ambos descubrieron este cálculo en forma independiente y casi simultánea entre 1670 y 1677, aunque fueron publicados unos cuantos años más tarde.

La difusión de las nuevas ideas fue muy lenta y al principio sus aplicaciones escasas. Los nuevos métodos tuvieron cada vez más éxito y permitieron resolver con facilidad muchos problemas. Los nuevos logros fueron sometidos a severas críticas, la justificación y las explicaciones lógicas y rigurosas de los procedimientos empleados no se dieron hasta avanzado el siglo XIX, cuando aparecieron otros matemáticos, más preocupados por la presentación final de los métodos que por su utilización en la resolución de problemas concretos.

El siglo XVIII

Durante buena parte del siglo los discípulos de Newton y Leibniz se basaron en sus trabajos para resolver diversos problemas de física, astronomía e ingeniería, lo que les permitió, al mismo tiempo, crear campos nuevos dentro de las matemáticas. Así, los hermanos Bernoulli inventaron el cálculo de variaciones y el matemático francés Monge la geometría descriptiva. Lagrange, también francés, dio un tratamiento completamente analítico de la mecánica, realizó contribuciones al estudio de las ecuaciones diferenciales y la teoría de números, y desarrolló la teoría de grupos. Su contemporáneo Laplace escribió Teoría analítica de las probabilidades (1812) y el clásico Mecánica celeste (1799-1825), que le valió el sobrenombre de "el Newton francés".

Sin embargo el gran matemático del siglo fue el suizo Euler, quien aportó ideas fundamentales sobre el cálculo y otras ramas de las matemáticas y sus aplicaciones. Euler escribió textos sobre cálculo, mecánica y álgebra que se convirtieron en modelos a seguir para otros autores interesados en estas disciplinas. El éxito de Euler y de otros matemáticos para resolver problemas tanto matemáticos como físicos utilizando el cálculo sólo sirvió para acentuar la falta de un desarrollo adecuado y justificado de las ideas básicas del cálculo. La teoría de Newton se basó en la cinemática y las velocidades, la de Leibniz en los infinitésimos, y el tratamiento de Lagrange era completamente algebraico y basado en el concepto de las series infinitas. Todos estos sistemas eran inadecuados en comparación con el modelo lógico de la geometría griega, y este problema no fue resuelto hasta el siglo posterior.

A los matemáticos de fines del siglo el horizonte matemático les parecía obstruido. Se había llegado al estudio de cuestiones muy complicadas a las que nos se les conocía o veía un alcance claro. Los sabios sentían la necesidad de estudiar conceptos nuevos y hallar nuevos procedimientos.

El siglo XIX

Un problema importante fue definir el significado de la palabra función. Euler, Lagrange y el matemático francés Fourier aportaron soluciones, pero fue el matemático alemán Dirichlet quien propuso su definición en los términos actuales. En 1821, un matemático francés, Cauchy, consiguió un enfoque lógico y apropiado del cálculo y se dedicó a dar una definición precisa de "función continua". Basó su visión del cálculo sólo en cantidades finitas y el concepto de límite. Esta solución planteó un nuevo problema, el de la definición lógica de número real. Aunque la definición de cálculo de Cauchy estaba basada en este concepto, no fue él sino el matemático alemán Dedekind quien encontró una definición adecuada para los números reales. Los matemáticos alemanes Cantor y Weierstrass también dieron otras definiciones casi al mismo tiempo.

Además de fortalecer los fundamentos del análisis, nombre dado a partir de entonces a las técnicas del cálculo, se llevaron a cabo importantes avances en esta materia. Gauss, uno de los más importantes matemáticos de la historia, dio una explicación adecuada del concepto de número complejo; estos números formaron un nuevo y completo campo del análisis, desarrollado en los trabajos de Cauchy, Weierstrass y el matemático alemán Riemann. Otro importante avance fue el estudio de las sumas infinitas de expresiones con funciones trigonométricas, herramientas muy útiles tanto en las matemáticas puras como en las aplicadas, hecho por Fourier. Cantor estudió los conjuntos infinitos y una aritmética de números infinitos. La teoría de Cantor fue considerada demasiado abstracta y criticada. Encontramos aquí un espíritu crítico en la elaboración de estas nociones tan ricas. Esto constituye un punto de vista muy diferente del que animaba a los matemáticos del siglo anterior. Ya no se trata de construir expresiones ni forjar nuevos métodos de cálculo, sino de analizar conceptos considerados hasta entonces intuitivos.

Gauss desarrolló la geometría no euclideana pero tuvo miedo de la controversia que pudiera causar su publicación. También en este siglo se pasa del estudio simple de los polinomios al estudio de la estructura de sistemas algebraicos.

Los fundamentos de la matemática fueron completamente transformados durante el siglo XIX, sobre todo por el matemático inglés Boole en su libro Investigación sobre las leyes del pensamiento (1854).

Siglo XX y nuestros días

Es importante el aporte realizado por Lebesgue referido a la integración y a la teoría de la medida y las modificaciones y generalizaciones realizadas por matemáticos que lo sucedieron.

En la Conferencia Internacional de Matemáticos que tuvo lugar en París en 1900, el matemático alemán David Hilbert, quien contribuyó de forma sustancial en casi todas las ramas de la matemática retomó veintitrés problemas matemáticos que él creía podrían ser las metas de la investigación matemática del siglo que recién comenzaba. Estos problemas fueron el estímulo de una gran parte de los trabajos matemáticos del siglo.

El avance originado por la invención del ordenador o computadora digital programable dio un gran impulso a ciertas ramas de la matemática, como el análisis numérico y las matemáticas finitas, y generó nuevas áreas de investigación matemática como el estudio de los algoritmos. Se convirtió en una poderosa herramienta en campos tan diversos como la teoría de números, las ecuaciones diferenciales y el álgebra abstracta. Además, el ordenador permitió encontrar la solución a varios problemas matemáticos que no se habían podido resolver anteriormente.

El conocimiento matemático del mundo moderno está avanzando más rápido que nunca. Teorías que eran completamente distintas se han reunido para formar teorías más completas y abstractas. Aunque la mayoría de los problemas más importantes han sido resueltos, otros siguen sin solución. Al mismo tiempo aparecen nuevos y estimulantes problemas y aún la matemática más abstractas encuentra aplicación.

Conclusiones

El progreso de las ideas no se da en el tiempo a través de una trayectoria perfectamente delineada y preconcebida; existen muchos elementos que en la construcción son desechados, reformulados o agregados. Las concepciones filosóficas sobre la realidad, el papel de la ciencia, y en especial las concepciones sobre las características que debe reunir el conocimiento matemático para ser considerado como conocimiento científico, determinaron los enfoques realizados en cada época. El impacto que tuvieron los personajes y las contribuciones consignadas en la historia difícilmente puede ser comprendida cabalmente si estas consideraciones no se toman en cuenta.

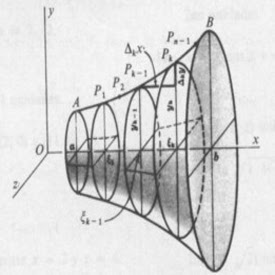

, con el rango

, con el rango  (para evitar la asíntota en

(para evitar la asíntota en  y

y  . Si se considera la parte del cuerno entre

. Si se considera la parte del cuerno entre  . Cuando a aumenta, el área no está acotada, mientras que el volumen tiene una cota superior de π.

. Cuando a aumenta, el área no está acotada, mientras que el volumen tiene una cota superior de π.